לוהטת: כאב הראש שעושה ה-AI לאנשי ה-IT

מערכות AI הן צרכניות כבדות של משאבי מחשוב, חדרי המחשב לרוב לא מותאמים לקירור נכון שלהן והביצועים נפגעים. איך מתמודדים עם צורך של KW100-300 לארון בודד וכיצד ייראו חדרי המחשב בעתיד?

מקור: dreamstime

מאת יקי שאלתיאל

מערכות ה-AI נחשבות לצרכניות כבדות מאוד של משאבי מחשוב, והשימוש ההולך וגובר בהן עושה למחלקות ה-IT כאב ראש לא קטן. ענפים שונים – בנקאות וביטוח, ביטחון, אקדמיה, טלקום, הייטק – נכנסים לשימוש מוגבר במערכות מבוססות GPU, המבצעות סימולציות מתקדמות, צ’טבוטים, מחקרים, תכנון שבבים, נהיגה אוטונומית ומה לא.

מי שכבר התחיל להשקיע בתשתיות עבור מערכות AI מגלה שהוא בבעיה – חדרי מחשב מסורתיים שתוכננו להרצת ארונות עם עומסים של KW3-5 במקרה הרע, או KW10-12 במקרה הטוב, מקבלים מכונות בגודל U4 (עשירית ארון) עם צריכה שיכולה בקלות להגיע ל-KW20. מערכות החשמל (הולכה ו-UPS) ומערכות הקירור שרובן מבוססות אוויר נשארות בלי אוויר – ונחנקות.

לנוכח העובדה שמכונה אחת לא ממש מספיקה וצריך Cluster של כמה מערכות כאלה, מתבססת ההבנה שנדרש פתרון שיוכל לענות על צרכים עכשוויים של ארונות עם צריכה של KW30-70, ובעתיד הקרוב מאוד (נניח שני רבעונים קדימה) גם KW100-300 לארון בודד.

עובדים מהר רק כשנעים להם

הסוכנות הלאומית לאנרגיה בארה”ב (IEA) דיווחה מוקדם יותר השנה שצריכת החשמל העולמית של חדרי מחשב, שעמדה על 2% עד 2022, תכפיל את עצמה עד 2026. גם בישראל המגמה דומה: חדרי מחשב לצורכי אירוח שתוכננו עד לפני שנתיים וכיוונו לצריכה של עד MW5, מתוכננים כרגע למינימום MW10 עבור IT.

על מנת לאפשר את מגמת אימוץ ה-AI הגואה, שקצב הגידול שלה פנומנלי (מספיק מבט במניות החברות שמתעסקות בתחום), חייבים לאפשר יעילות מקסימלית על מנת לייצר כמה שיותר כוח חישוב לכל קילוואט מושקע.

אך מעבדים אוהבים לעבוד מהר רק כשנעים להם. כלומר, ככל שמשאבי המחשוב דורשים יותר אנרגיה, הם דורשים במקביל גם יותר יכולות קירור לשרתים, המתאמצים לעבד את המודלים ומייצרים חום. כאשר מעבדים מתחממים, קצב השעון והביצועים יורדים במקביל. הבעיה היא שחדרי המחשב של היום פשוט לא בנויים להתמודד עם דרישות הקירור המתאימות לאפשר למערכות המפלצתיות האלה לרוץ כמו שצריך.

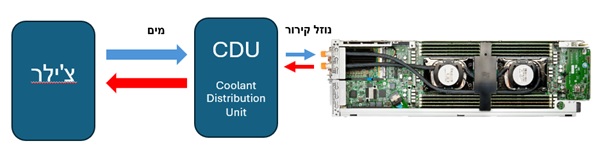

עד כה עבדה שיטת קירור מסורתי, שבו מזרימים אוויר קר לתוך השרתים. אך לצריכה של מערכות AI נדרשת שיטה יעילה יותר, כמו קירור נוזלי ובמיוחד בתצורה של קירור ישיר Direct Liquid Cooling – DLC. בשיטה זו נוזל קירור זורם בצינורית עד למגע ישיר במעבדים וסופג מהם את החום, שמועבר עם הנוזל חזרה ליחידת הקירור, שמעבירה אותו הלאה ליחידות מחוץ לחדר המחשב (למשל מגדל קירור או צ’ילר).

הצ’ילר שולח מים קרים לתוך חדר המחשב, בדיוק כמו מה שקורה היום בחדרי המחשב עם מערכות קירור אוויר מסורתיות, אבל הוא מקרר יחידת CDU (יחידת הפצת נוזל קירור) שיושבת בתוך הארון ותפקידה להזרים נוזל קירור לשרתים. נוזל הקירור חוזר חם ל-CDU, מתקרר שם וחוזר חלילה. אלו שני מעגלים נפרדים. נוזל הקירור הוא דיאלקטרי (לא מוליך), כך שגם במקרה של פריצת נוזל לא ייווצר נזק לציוד.

חדרי המחשב ייראו אחרת לגמרי

אך שיטה זו לא מתאימה לחדרים קיימים. מערכות הקירור של מעגל המים חייבות להיות בעלות מסוגלות לטפל בכמות גדולה מאוד של מים בו זמנית, עם צנרת ייעודית שמגיעה לכל ארונות ה-AI. רק חדרי מחשב, שנבנים מראש למטרה זאת, יכולים לעמוד במשימה המורכבת, שכן אם מערכות הקירור, כולל קוטר הצינורות והמיקום שלהם לצורכי חיבור ליחידות CDU, לא תוכננו מראש, אזי זו תהיה בעיה קשה.

גם מבחינת חלוקת חשמל קיים אתגר לא קטן. היום ארונות “כבדים” בחדרי מחשב מתוכננים ל-KW22 על בסיס שני פסי שקעים של 32 אמפר תלת פאזי. על מנת להגיע לאספקת חשמל לארון של KW100 נדרשים 10 פסי שקעים כאלה – וזה פשוט לא מעשי. הפתרון הוא מעבר לזוגות או רביעיות של פסי שקעים של 63 אמפר, דבר שמחייב גם ארונות חשמל משודרגים ומערכת הולכה מתאימה. כבר עכשיו הוכרזו פסי שקעים של 120 אמפר ועוד היד נטויה.

תוצר נוסף של מערכות AI הוא הדחיסות המאוד גבוהה שלהן. מכיוון שמאווררים והציוד הדרוש כדי לתמוך בפתרונות מקוררי אוויר אינם נחוצים לקירור נוזלי, אולמות מחשב יכולים להציב פחות יחידות שרתים ולחסוך מקום רב. כך לדוגמה, מרכז נתונים עם 10,000 שרתים עם קירור נוזלי ישיר מוריד 77.5% מן השטח הדרוש בהשוואה לשרתים עם קירור אוויר.

כבר ברור שמערכות AI מהדור הקרוב דורשות קירור כמו מחשבי על לצורך עמידה בדרישות הזמינות, היעילות והקיימות. בקירור נוזלי ישיר אפשר לספק מערכת יעילה מספיק, כלומר עד פי 3 מקירור אוויר, ולספוג בתכנון נכון את החום של המעבד ב-CPU וב-GPU וגם של הזיכרון ורכיבי התקשורת. בשיטה זאת היעילות עולה ב-20% ופליטת הפחמן יורדת ב-87%.

צריך להתרגל לכך שחדרי מחשב של AI הם קטנים בהרבה – בממוצע סביבות AI תופסות 20% מול שטח מקביל של מערכות IT. חדרי המחשוב בעתיד יכילו כמה עשרות ארונות שבהם כמות עצומה של ליבות של AI על בסיס GPU, ורוב החדר יהיה מיועד למערכות החשמל והקירור.

הכותב הוא מנהל תחום תשתיות היברידיות, חטיבת הייעוץ והפרויקטים, HPE